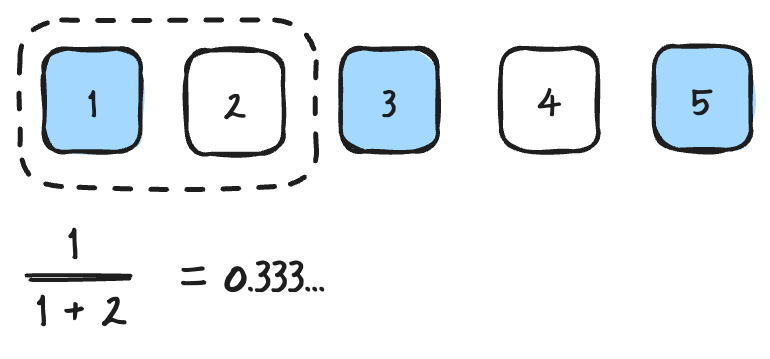

> https://amitness.com/posts/information-retrieval-evaluation 글을 읽고 정리한 문서입니다. ## 지표의 목적 상위 N 결과가 얼마나 우수한지 어떻게 평가할 것 인가? ### Binary relevance - 문서에 대한 관련성을 `있다 / 없다` 로만 판단한다. - 현재 Ranking model 이 query 에 대해서 5개의 각각의 문서 관련도는 `[1, 0, 1, 0, 1]` 로 나타낼 수 있다. (*binary*) ## Order-unaware metrics ### Precision@k $$ Precision@k = \frac{ true\ positives@k}{(true\ positives@k) + (false\ positives@k)} $$ - 이 메트릭은 상위 K 결과의 관련 항목 수를 정량화합니다. - 추출된 k 랭크 문서 중에서 관련 있는 문서의 갯수 예시) *Precision@2* ### Recall@k $$ Recall@k = \frac{ true\ positives@k}{(true\ positives@k) + (false\ negatives@k)} $$ - 이 메트릭은 쿼리에 대한 모든 실제 관련 결과 중에서 몇 개의 실제 관련 결과가 표시되었는지 알려줍니다. - 전체 관련 있는 문서 갯수 중에서 k 랭크 내에 추출된 관련 있는 문서의 갯수 예시) *Recall@2* ### 참고: Precision 과 Recall 의 집합관계 - A = 모델에서 문서가 관련 있다고 예측한 영역 (예측) - B = 실제 관련 있는 문서가 있는 영역 (정답) - b 영역 = True Positive 로 모델이 추출한 관련 문서 중 실제 관련 있는 문서가 있었던 영역 모델이 반환한 결과 중에서 실제 관련도 있는 문서를 추출한 비율이 precision, 실제 관련 있는 문서 목록 중 model 이 올바르게 문서를 추출한 비율이 recall 이라고 할 수 있다. ### F1@k $$ F1@k = \frac{2*(Precision@k) * (Recall@k)}{(Precision@k) + (Recall@k)} $$ - precision 과 Recall 의 조화평균으로 계산한다. - 조화 평균은 산술 평균보다 비중의 평균을 계산할 때 더 직관적이다. precision 과 recall 모두 중요한 값이기 때문에, 두 값 모두 높을 때 랭킹 모델의 성능이 더 좋다고 말할 수 있다. 따라서 두 값이 조화롭게 좋을 때 가장 높은 조화 평균을 사용한다. > - [The truth of the F-measure](https://www.cs.odu.edu/%7Emukka/cs795sum09dm/Lecturenotes/Day3/F-measure-YS-26Oct07.pdf) > **조화 평균** > #### 참고. 조화평균 개별 데이터의 역수의 평균에 대한 역수이다. 조화 평균은 비율의 평균을 계산하는 데 자주 사용되는데, 각 데이터의 가중치가 동일하기 때문에 비율에 대한 가장 적절한 측정이다. 예를 들어, 산술 평균은 큰 데이터 에 높은 가중치를 부여되고 기하 평균은 작은 데이터 요소에 낮은 가중치를 부여되는데 비해 조화평균은 전체적으로 동일한 가중치가 부여된다. 다음 표는 산술평균은 모두 같게 평가되지만, 조화평균은 각각 다름을 알 수 있다. | A | B | 산술평균 | 조화평균 | | -- | -- | ---- | ---- | | 10 | 0 | 5 | 0 | | 9 | 1 | 5 | 1.8 | | 8 | 2 | 5 | 3.2 | | 7 | 3 | 5 | 4.2 | | 6 | 4 | 5 | 4.8 | | 5 | 5 | 5 | 5 | | 4 | 6 | 5 | 4.8 | | 3 | 7 | 5 | 4.2 | | 2 | 8 | 5 | 3.2 | | 1 | 9 | 5 | 1.8 | | 0 | 10 | 5 | 0 | 조화평균은 표에서 확인할 수 있는 것처럼, 두 값이 조화롭게 존재할 때 가장 높게 평가된다 (산술 평균과 같다). 또한 산술평균에 비해 큰 비중이 끼치는 편향이 줄어든다고 볼 수 있다. ## Order-aware metrics ### Mean Reciprocal Rank(MRR, Rank 역수 평균) $$ MRR = \frac{1}{|Q|} \sum_{i=1}^{|Q|} \frac{1}{rank_{i}} $$ where: - $|Q|$ denotes the total number of queries - $rank_{i}$ denotes the rank of the first relevant result - 이 메트릭은 시스템이 가장 적절한 항목을 반환하고 해당 항목이 더 높은 위치에 있기를 원할 때 유용합니다. ### Average Precision(AP, Precision 평균) $$ AP = \frac{\sum_{k=1}^{n} (P(k) * rel(k))}{number\ of\ relevant\ items} $$ where: - $rel(k)$ is an indicator function which is 1 when the item at rank K is relevant. - $P(k)$ is the $Precision@k$ metric - Average Precision은 모델이 선택한 모든 실측 관련 항목의 순위가 더 높은지 여부를 평가하는 지표입니다. MRR과 달리 모든 관련 항목을 고려합니다. Example 1) Example 2) ### Mean Average Precision $$ MAP = \frac{1}{Q} \sum_{q=1}^{Q} AP(q) $$ where - $Q$ is the total number of queries - $AP(q)$ is the average precision for query $q$. - 여러 쿼리에 걸쳐 평균 정밀도를 평가하려면 MAP를 사용할 수 있습니다. ## RAGAS 에서 측정하고 있는 지표 ### Context Utilization (Context Precision) > [https://docs.ragas.io/en/latest/concepts/metrics/context_precision.html](https://docs.ragas.io/en/latest/concepts/metrics/context_precision.html) > > - context utilization 은 context precision 에서 ground truth 가 아닌 llm 답변을 사용하는 지표이다. - 답변을 정답이라고 가정했을 때, 반환된 context 에서 관련된 문서가 높게 랭킹되었는 지를 수치화한다. - retriever 의 성능 지표로 사용 $$ \text{Context Precision@K} = \frac{\sum_{k=1}^{K} \left( \text{Precision@k} \times v_k \right)}{\text{Total number of relevant items in the top } K \text{ results}} $$ $$ \text{Precision@k} = {\text{true positives@k} \over (\text{true positives@k} + \text{false positives@k})} $$ where: - $K$ 는 context 내 Chunk 수 - $v_k \in {0, 1}$ 은 $k$ 랭크에 위치한 문서가 관련되어 있는 지 없는 지를 나타내는 지표이다. ### Answer Relevancy > [https://docs.ragas.io/en/latest/concepts/metrics/answer_relevance.html](https://docs.ragas.io/en/latest/concepts/metrics/answer_relevance.html) - 답변에 기반하여 생성한 질문들의 Embedding vector 와 실제 질문의 embedding vector 를 cosine similarity 로 비교하여 연관도를 측정한다. $$ \text{answer relevancy} = \frac{1}{N} \sum_{i=1}^{N} cos(E_{g_i}, E_o) $$ $$ \text{answer relevancy} = \frac{1}{N} \sum_{i=1}^{N} \frac{E_{g_i} \cdot E_o}{\|E_{g_i}\|\|E_o\|} $$ ### Context Relevancy > [https://docs.ragas.io/en/latest/concepts/metrics/context_relevancy.html](https://docs.ragas.io/en/latest/concepts/metrics/context_relevancy.html) - context 에 포함된 문장이 답변과 얼마나 연관되어 있는 지를 나타낸다. $$ \text{context relevancy} = {|S| \over |\text{Total number of sentences in retrieved context}|} $$ ## 참고 링크 - https://sumniya.tistory.com/26 - https://amitness.com/posts/information-retrieval-evaluation#mean-average-precisionmap

서비스 요구사항에 따라 Client IP 가 필요한 상황이 있다. 보안을 위해서 Client IP 를 확인하여 접근을 허용할 수 있다. 허용되지 않은 IP 의 경우 접근을 막을 수 있다. 로그 요구사항으로 어떤 사용자가 접근하고 있는 지를 기록하기 위해 Client IP 를 남겨야 할 수 있다. 하지만 사용자나 서비스의 네트워크 구성에 따라서 Client IP 를 추출하는 것이 쉽지 않을 수 있다. 프록시가 있어 직접 연결한 Client 를 실제 사용자로 판단할 수 없는 경우가 그렇다. 프록시 뒤에 있는 사용자를 찾으려고 노력하면 Client IP 를 숨기거나 우회하기 위해서 변조를 시도하는 상황을 마주하게 된다. 그래서 Client IP 를 추출하기 위한 여러 방안들을 아래에 정리하게 되었다. 결론부터 먼저 말하면, 일반적인 상황에서 나는 `X-Forwarded-For` 의 가장 오른쪽의 Public IP 를 Client IP 로 판단하기로 했다. 믿을 수 없는 목록 중에서 신뢰할 수 있으면서 간단하고, 빠른 방법이라 생각하기 때문이다. 하지만 여러 방안들을 조사했을 때, 어떤 상황에서는 사용할 수 있는 지, 또 어떤 지점이 문제가 되는 지 생각해볼 수 있었다. 그래서 고민했었던 여러 방안들을 소개하려고 한다. ### Remote IP 프록시가 없는 간단한 구조의 서비스라면 서버에 연결된 Remote IP 를 Client IP 로 추출할 수 있다. 하지만 Remote IP 가 실제 사용자의 IP 라는 확신이 없다면, Client IP 로 사용하기 어렵다. 사용자 네트워크 구성에서 proxy 가 있다면, 서버에 연결된 Remote IP 는 실제 사용자의 Client IP 가 아닐 수 있다. 여기에서 서비스 요구사항에 대한 명확한 정의가 필요해질 수 있다. 사용자 네트워크의 사설 IP 를 추출해야 하는 지, 아니면 공인 IP 를 추출해야 하는 지 정의가 필요하다. 사설 IP 는 서비스의 입장에서 큰 의미가 없기 때문에, 보통 공인 IP...

댓글

댓글 쓰기